GaussianFormer3D

约 8847 字大约 29 分钟

2025-06-09

注

Lingjun Zhao†, Sizhe Wei, James Hays, Lu Gan Georgia Institute of Technology, Atlanta, GA USA

2025

代码暂未开源

https://lunarlab-gatech.github.io/GaussianFormer3D/

摘要

3D语义占据预测对于实现安全可靠的自动驾驶至关重要。与仅使用摄像头的感知系统相比,多模态流程,尤其是激光雷达 - 摄像头融合方法,能够产生更准确、更详细的预测。尽管大多数现有工作采用密集网格表示法,将整个3D空间均匀划分为离散的体素,但3D高斯的出现提供了一种紧凑且连续的对象中心表示法。在本工作中,我们提出了一个利用3D可变形注意力的多模态基于高斯的语义占据预测框架,名为GaussianFormer3D。我们引入了一种体素到高斯初始化策略,为3D高斯提供来自激光雷达数据的几何先验,并设计了一种激光雷达引导的3D可变形注意力机制,用于在提升的3D空间中用激光雷达 - 摄像头融合特征细化3D高斯。我们在道路和非道路数据集上进行了广泛的实验,结果表明,我们的GaussianFormer3D在预测精度上达到了与基于多模态融合的最先进方法相当的高水平,同时减少了内存消耗并提高了效率。项目网站

1. Intro

自动驾驶车辆的感知系统对于构建安全可靠的自动驾驶至关重要。在众多感知任务中,3D语义占据预测尤为重要,因为它能够实现对环境语义和几何信息的细粒度理解。最近在基于视觉的占据预测方面的进展已经在大规模数据集上展现出令人印象深刻的性能。然而,摄像头传感器对光照条件敏感,并且缺乏准确的深度估计,这促使研究人员将其他传感器模态整合进来,以增强自动驾驶感知系统的鲁棒性。

激光雷达传感器已被广泛应用于自动驾驶中的感知任务,例如3D目标检测。与摄像头相比,激光雷达提供了更准确的深度信息,并且能够捕捉到物体之间更精细的几何关系,这使得激光雷达在3D语义占据预测方面具有特别的优势。然而,基于激光雷达的流程可能在捕捉小物体的准确语义信息方面存在困难,而基于摄像头的方法在这方面表现出色。为了平衡语义和几何信息,提出了基于多模态融合的算法,以利用不同传感器的优势。融合型语义占据预测方法包括激光雷达 - 摄像头融合、摄像头 - 雷达融合以及激光雷达 - 摄像头 - 雷达融合。在这些传感器配置中,激光雷达 - 摄像头融合是最受欢迎且表现最佳的。

大多数现有的激光雷达 - 摄像头占据网络采用基于3D体素或基于2D鸟瞰图(BEV)的表示法来描绘3D场景,尽管它们能够实现相当的性能,但不可避免地会受到冗余空网格和高计算成本的困扰。

最近,受3D高斯绘制成功的启发,一种新的以对象为中心的表示法首次被探索用于基于视觉的3D语义占据预测。GaussianFormer将3D场景表示为一组3D高斯,每个高斯由均值、协方差和语义标签组成。这些高斯通过2D可变形注意力机制进行细化,然后通过高效的高斯到体素绘制模块来预测语义占据。然而,当前基于高斯的方法仅依赖于2D图像反馈来更新3D高斯,限制了它们对3D空间进行准确深度信息和细粒度几何结构建模的能力。如何利用来自其他模态的数据,例如激光雷达,来细化并获得更准确的3D高斯表示,以实现更高效、更准确的语义占据预测,仍然是一个未被探索的问题。

注

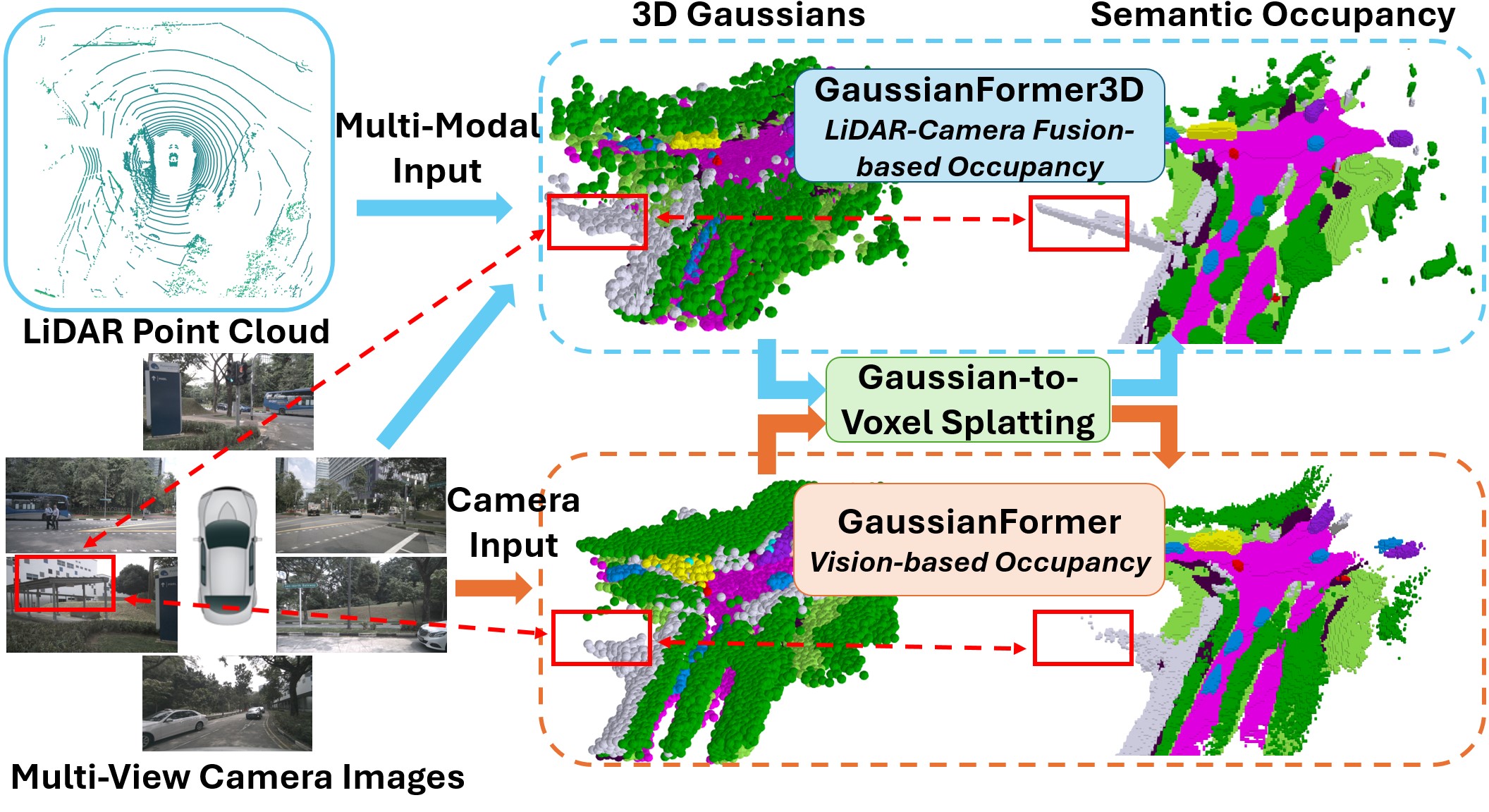

图 1. 我们提出了一个基于激光雷达 - 摄像头融合的语义占据预测框架,名为 GaussianFormer3D。我们使用 3D 高斯而不是密集网格来减少内存消耗,并提高算法效率。GaussianFormer3D 在预测精度上达到了与基于多模态融合的最先进方法相当的水平,同时减少了内存使用。

基于上述观察,我们提出了 GaussianFormer3D:一个基于多模态高斯的语义占据预测框架,利用 3D 可变形注意力。如图 1 所示,GaussianFormer3D 使用从激光雷达体素特征初始化的 3D 高斯来建模场景,在统一的 3D 特征空间中通过激光雷达 - 摄像头融合特征更新高斯,最后通过高斯到体素绘制模块预测语义占据。据我们所知,GaussianFormer3D 是首个采用基于高斯的对象中心场景表示的多模态语义占据网络。总结来说,我们的主要贡献如下:

我们提出了一个新颖的基于多模态高斯的语义占据预测框架。通过整合激光雷达和摄像头数据,我们的方法在类似内存使用量的情况下显著优于仅使用摄像头的基线。

我们设计了一个体素到高斯初始化模块,为 3D 高斯提供来自激光雷达数据的几何先验。我们还开发了一种增强的 3D 可变形注意力机制,通过在提升的 3D 空间中聚合激光雷达 - 摄像头融合特征来更新高斯。

我们在两个道路数据集 nuScenes-SurroundOcc 和 nuScenes-Occ3D 以及一个非道路数据集 RELLIS3D-WildOcc 上进行了广泛的评估。结果表明,我们的方法在性能上与基于密集网格的最先进方法相当,同时具有降低的内存消耗和提高的效率。

2. 相关工作

多模态语义占据预测

多模态占据方法通常优于单模态方法,因为不同模态可以相互补充。

常见的多模态语义占据传感器配置包括激光雷达 - 摄像头、摄像头 - 雷达以及激光雷达 - 摄像头 - 雷达。其中,激光雷达 - 摄像头是最优的配置,因为它结合了激光雷达精确的深度和几何感知以及摄像头强大的语义感知能力。

与单模态流程类似,现有的激光雷达 - 摄像头占据网络主要基于体素表示或 BEV 表示构建。

- CONet 提出了一种从粗到细的流程,用于采样 3D 体素特征以细化粗占据预测。

- Co-Occ 通过几何和语义感知融合模块获得多模态体素特征,并采用基于 NeRF 的隐式体积渲染正则化来增强融合表示。

- OccGen 和 OccMamba 分别通过编码多模态输入产生体素融合特征,然后使用扩散去噪和层次化 Mamba 模块解码特征以预测语义占据。

- OccFusion 通过 2D 可变形注意力将激光雷达和摄像头输入转换为多模态体素特征,随后通过占据头进行预测。

3D 高斯在自动驾驶中的应用

由于 3D 高斯在明确且连续地建模场景方面的固有优势,3D 高斯已被采用作为传统基于网格解决方案在 3D 语义占据预测中的场景表示。3D 高斯还因其在实时图像渲染和新视图合成方面的优势而被采用,因此也被用于驾驶场景重建和仿真。此外,端到端自动驾驶和视觉预训练利用 3D 高斯作为驾驶世界表示,用于各种下游感知和规划任务。然而,这些方法主要针对仅使用摄像头的自动驾驶设计,忽略了多模态数据在高斯初始化和更新中的潜力。GSPR 提出了一种基于高斯的多模态位置识别算法,SplatAD 设计了首个 3D 高斯绘制流程以渲染激光雷达和摄像头数据。在本工作中,我们探索利用多模态数据,尤其是来自激光雷达和摄像头的数据,以学习更好的 3D 高斯表示,从而实现更准确、更高效的语义占据预测。

3. 方法

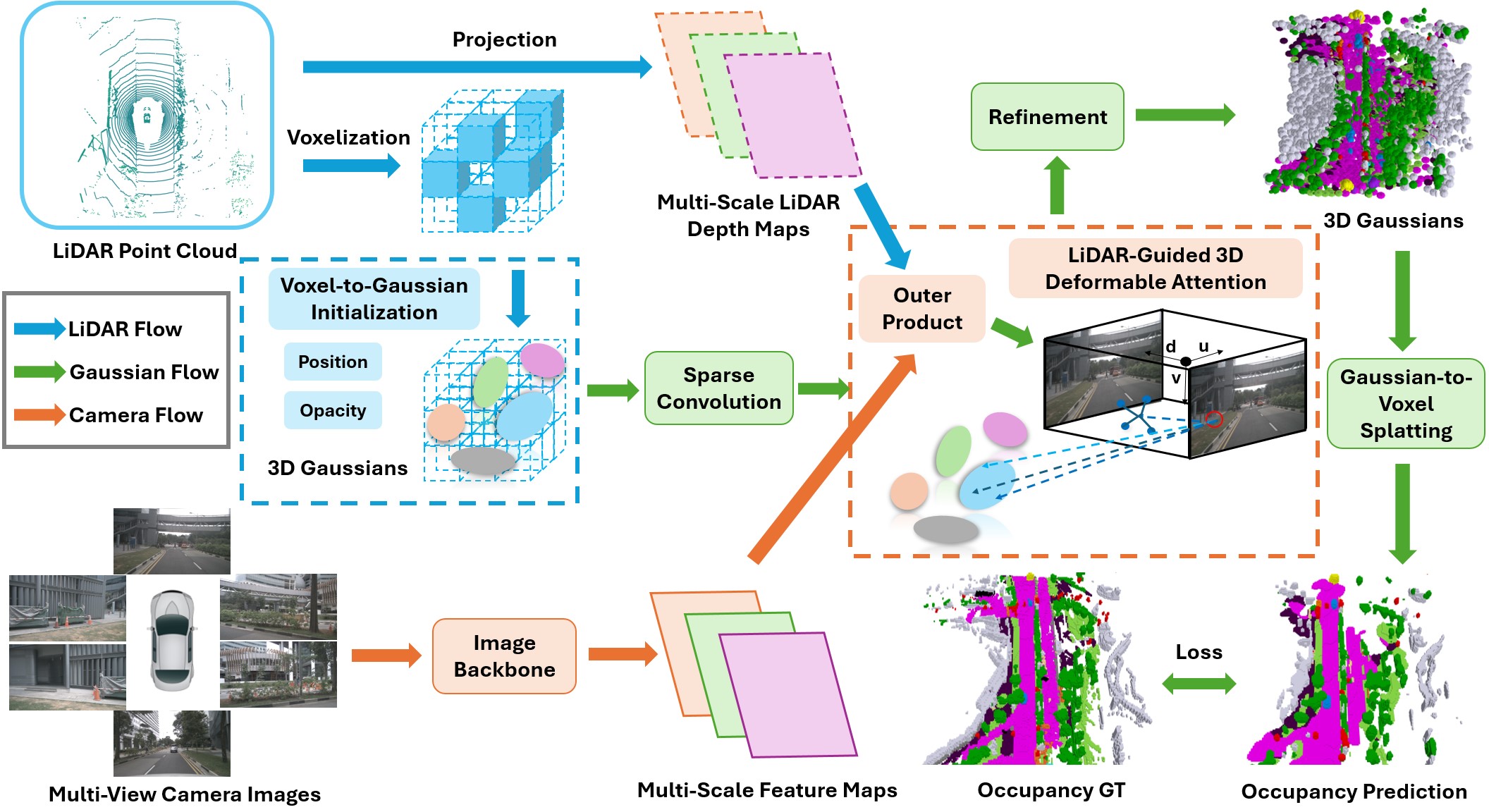

GaussianFormer3D 的总体架构如图 2 所示。

注

图 2. 本文提出的 GaussianFormer3D 框架的总体架构。我们首先将激光雷达点云体素化,以获取用于初始化 3D 高斯位置和不透明度的非空体素特征 [28]。然后,通过投影和图像主干网络分别提取多尺度激光雷达深度图和摄像头特征图,并通过外积运算构建提升的 3D 融合特征空间。通过 3D 稀疏卷积、3D 可变形注意力和属性细化模块迭代更新高斯。最终,高斯表示通过高斯到体素绘制模块 [25] 处理,以生成密集的 3D 语义占据。

3.1 基于3D高斯的场景表示

语义占据预测的目标是同时理解环境的语义信息和几何结构。在多模态场景中,给定多视角相机图像 I={Ii}i=1Nc 和激光雷达点云 P={Pi}i=1Np(其中 Pi=(xi,yi,zi,ηi) 包含点的3D位置和强度),任务是预测语义占据网格 O∈CX×Y×Z。这里 Nc、Np、C 和 X×Y×Z 分别表示相机视角数量、激光雷达点数、语义类别集合和体素网格大小。

与传统密集网格表示不同,3D高斯表示能够自适应地建模感兴趣区域,这得益于高斯混合的通用逼近能力[11, 25]。具体来说,场景被建模为一组3D高斯分布 G={Gi}i=1Ng,其中每个高斯 Gi 由均值 mi∈R3、旋转 ri∈R4、尺度 si∈R3、透明度 σi∈[0,1] 和语义标签 ci∈R∣C∣ 参数化。Ng 是表示场景的高斯总数。高斯 G 在位置 x 处的值可通过以下公式计算:

g(x;G)=σ⋅exp(−21(x−m)TΣ−1(x−m))c,(1)

Σ=RSSTRT,S=diag(s),R=q2r(r),(2)

其中 Σ、R 和 S 分别表示协方差矩阵、旋转矩阵和尺度矩阵。diag(⋅) 是对角矩阵构造函数,q2r(⋅) 是四元数到旋转矩阵的转换函数。

通过累加所有高斯在位置 x 处的贡献,占据预测可表示为:

o^(x;G)=i=1∑Nggi(x;mi,si,ri,σi,ci).(3)

为了提高效率并减少不必要的计算和存储,高斯到体素的泼溅模块仅聚合目标体素邻域内的高斯,而非查询场景中的所有高斯[25]。因此,式(3)可以进一步近似为仅累加位置 x 邻域内的高斯数量 Ng(x)。训练时,高斯占据模型通过交叉熵损失 Lce 和 Lovász-Softmax损失 Llov[2] 进行端到端监督。

3.2 体素到高斯的初始化

我们的模型采用两组3D高斯特征:

- 可学习的高斯物理属性 G={Gi∈Rd}i=1Ng(d=11+∣C∣),即3.1节中的目标参数。

- 不可学习的高维高斯特征 Q={Qi∈Rm}i=1Ng(m 为特征维度),作为注意力机制的查询[7, 65, 94],隐式编码高斯更新的空间和语义信息。

以往工作[25]在训练时随机初始化高斯物理属性,并通过多次重复的细化模块迭代优化。这种设计限制了高斯仅从2D图像学习复杂的3D几何信息,导致空间建模不准确。

为解决这一问题,我们提出基于激光雷达的体素到高斯初始化策略,用激光雷达数据提供的几何先验初始化高斯的均值和透明度(图2蓝色虚线框)。具体步骤:

- 将最近的 Nf 帧激光雷达扫描合并为点云 Pˉ={Pi}i=1Nf。

- 对合并点云进行体素化,计算每个非空体素的特征(其内所有点的平均位置和强度)[93]。

- 用这些体素特征初始化高斯的位置和透明度:

mi=∣Pv∣1j∈Pv∑(xj,yj,zj),σi=∣Pv∣1j∈Pv∑ηj,

其中 i∈{1,…,Ng} 为待初始化高斯的索引,v∈{1,…,Nv} 为非空体素索引,Pv 为落入体素 v 的激光雷达点集。

若 Ng<Nv,则随机选择 Ng 个非空体素初始化高斯;反之则随机选择 Nv 个高斯进行初始化。

初始化后,通过3D稀疏卷积模块对高斯进行自编码,高效提取和聚合高斯信息以更新查询。

3.3 激光雷达引导的3D可变形注意力

"Lift, Splat, Shoot" (LSS)[54] 和基于2D注意力的方法[7, 94] 常用于将多视角2D图像特征提升至3D空间。但LSS计算成本高,难以应用于多尺度特征;而2D可变形注意力缺乏深度信息,导致不同3D高斯投影到相同2D位置时可能聚合相同特征。

3D可变形注意力算子DFA3D[1] 通过单目深度估计将2D特征扩展至3D,再应用注意力机制。受此启发,我们提出激光雷达引导的3D可变形注意力机制(图2橙色虚线框):

- 构建统一的3D特征空间:通过激光雷达深度图 Fd 与相机多尺度特征 Fc 的外积生成 F3D=Fd⊗Fc。

- 两阶段采样:

- 为每个高斯生成一组3D参考点 RG={mi=m+Δmi}(通过学习的偏移量 Δm)。

- 将这些参考点投影至 F3D 空间,得到 m~i=(ui,vi,di)。

- 为每个投影参考点生成可学习的采样偏移 Δm~ij=(Δuij,Δvij,Δdij)。

最终采样点集为:

RˉG={m~ij=m~i+Δm~ij}.

- 高斯查询更新:通过加权聚合多模态特征 ΔQ 更新高斯查询:

ΔQ=Nc1c=1∑Nci,j∑DFA(Q,πc(m~ij;T,K),Fc3D),

其中 DFA(⋅) 为3D可变形注意力操作,πc(⋅) 为从高斯坐标系到相机 c 的 Fc3D 坐标系的变换。

通过稀疏卷积和3D可变形注意力获取足够的3D几何与语义信息后,高斯查询 Q 经MLP解码以细化高斯属性 G。我们通过 B 个稀疏卷积、3D可变形注意力和细化模块的迭代块优化高斯属性。

4. 实验

4.1. 数据集

NuScenes [4] 数据集提供了 1000 个驾驶场景序列,这些序列是通过 6 个环绕摄像头、1 个激光雷达、5 个雷达和 1 个惯性测量单元(IMU)收集的。每个序列持续 20 秒,并以 2Hz 的频率进行标注。SurroundOcc [70] 和 Occ3D [64] 都为 NuScenes 数据集提供了语义占据标注,分别包含 700 和 150 个场景用于训练和验证,涵盖 18 个类别(即 16 个语义类别、1 个噪声类别和 1 个空类别)。不同之处在于,SurroundOcc 在范围 [−50m,50m]×[−50m,50m]×[−5m,3m] 内将场景划分为体素,分辨率为 0.5m,而 Occ3D 在范围 [−40m,40m]×[−40m,40m]×[−1m,5.4m] 内将场景划分为体素,分辨率为 0.4m。Occ3D 还提供了摄像头可见性掩码。

RELLIS-3D [27] 数据集是一个多模态非道路驾驶数据集,包含 RGB 图像、激光雷达点云、立体图像、GPS 和 IMU 数据。WildOcc [83] 在 RELLIS-3D 上提供了首个非道路占据标注,这些标注被划分为 7399/1249/1399 帧,分别用于训练、验证和测试。标注范围为 [−20m,0m]×[−10m,10m]×[−2m,6m],每个体素的分辨率为 0.2m,并被标记为 9 个类别之一(7 个语义类别、1 个其他类别和 1 个空类别)。WildOcc [83] 用于评估我们的模型在非道路场景上的性能,采用激光雷达 - 单目设置。

4.2. 实现和评估细节

对于摄像头分支,我们将 nuScenes [4] 的输入图像分辨率设置为 900×1600,RELLIS-3D [27] 的输入图像分辨率设置为 1200×1920。我们使用在 FCOS3D [67] 上预训练的 ResNet101-DCN [15] 作为主干网络,并使用 FPN [40] 作为颈部网络。对于激光雷达分支,我们聚合并体素化前 10 次扫描的点云,并通过体素特征编码器 [93] 获得平均特征。激光雷达深度图在训练前生成并保存,遵循 [^31, 35]。高斯的数量在我们的主要实验中设置为 25,600。我们使用这些高斯仅对占据空间进行建模,并将空闲空间留给一个固定的大型高斯以提高效率 [23]。我们使用 AdamW [42] 优化器进行训练,权重衰减为 0.01。学习率分别设置为 nuScenes 的 1×10−4 和 RELLIS-3D 的 3×10−4,并采用余弦退火计划进行衰减。我们在 nuScenes 上训练了 24 个周期,批量大小为 8,在 RELLIS-3D 上训练了 20 个周期,批量大小为 4,训练均在 Nvidia A40 GPU 上进行。我们使用交并比(IoU)和平均交并比(mIoU)作为评估指标,遵循 MonoScene [5]。有关指标计算细节,请参阅补充材料。

4.3. 定量结果

3D 语义占据预测性能

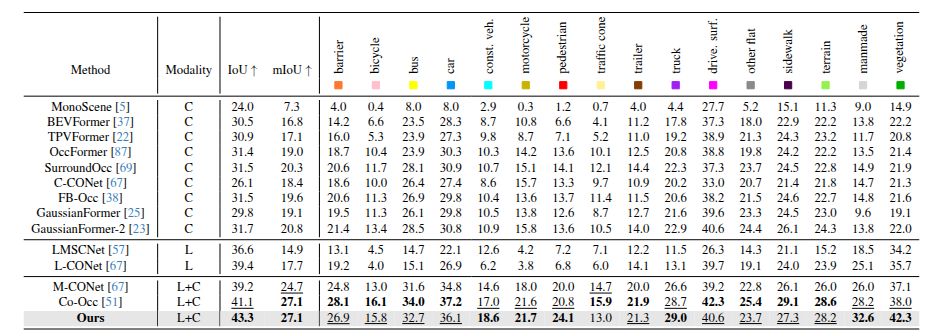

注

表1. 在SurroundOcc [70]验证集上的三维语义占位预测结果。最佳结果以粗体标出,次佳结果以_下划线_标出。我们的方法在总体性能上与基于激光雷达 - 相机融合的最新方法相当,但在小物体、动态车辆和大平面类别的表现上超越了它们。

我们在 SurroundOcc [70]、Occ3D [64] 和 WildOcc [83] 上报告了 GaussianFormer3D 的性能,分别见表 1、表 2 和表 3。对于表 1 和表 2 中的道路场景,我们的方法在所有类别上都显著优于 GaussianFormer [25],在 SurroundOcc [70] 上 IoU 和 mIoU 分别提高了 13.5 和 8.0,在 Occ3D [64] 上 mIoU 提高了 10.9。与最先进的激光雷达 - 摄像头方法 [52, 68, 87] 相比,GaussianFormer3D 实现了相当的整体性能,同时在预测小物体(例如摩托车、行人)、动态车辆(例如汽车、施工车辆、卡车)和周围表面(例如人造结构、植被)等对自动驾驶任务至关重要的类别时表现出色。这一改进归功于高斯的通用近似能力,能够以灵活的尺度和形状对物体进行建模。对于表 3 中的非道路结果,我们的单帧图像输入方法在 IoU 上超过了使用 4 个连续图像的 M-OFFOcc [83] 1.1,在 mIoU 上表现相当。此外,我们的方法在测试集上比 GaussianFormer [25] 在 IoU 上提高了 14.4,在 mIoU 上提高了 6.8,突出了激光雷达在理解复杂非道路地形几何结构方面的作用。GaussianFormer3D 在预测大面积区域(如草地、树木和水坑)方面表现出色,但在细微地形变化(如泥泞)方面仍不理想。对于障碍物和碎石,由于它们在测试集中出现频率低(仅占占据体素的 0.001%),由于缺乏足够的特征来进行可靠预测,这构成了挑战。更多分析请参阅补充材料。

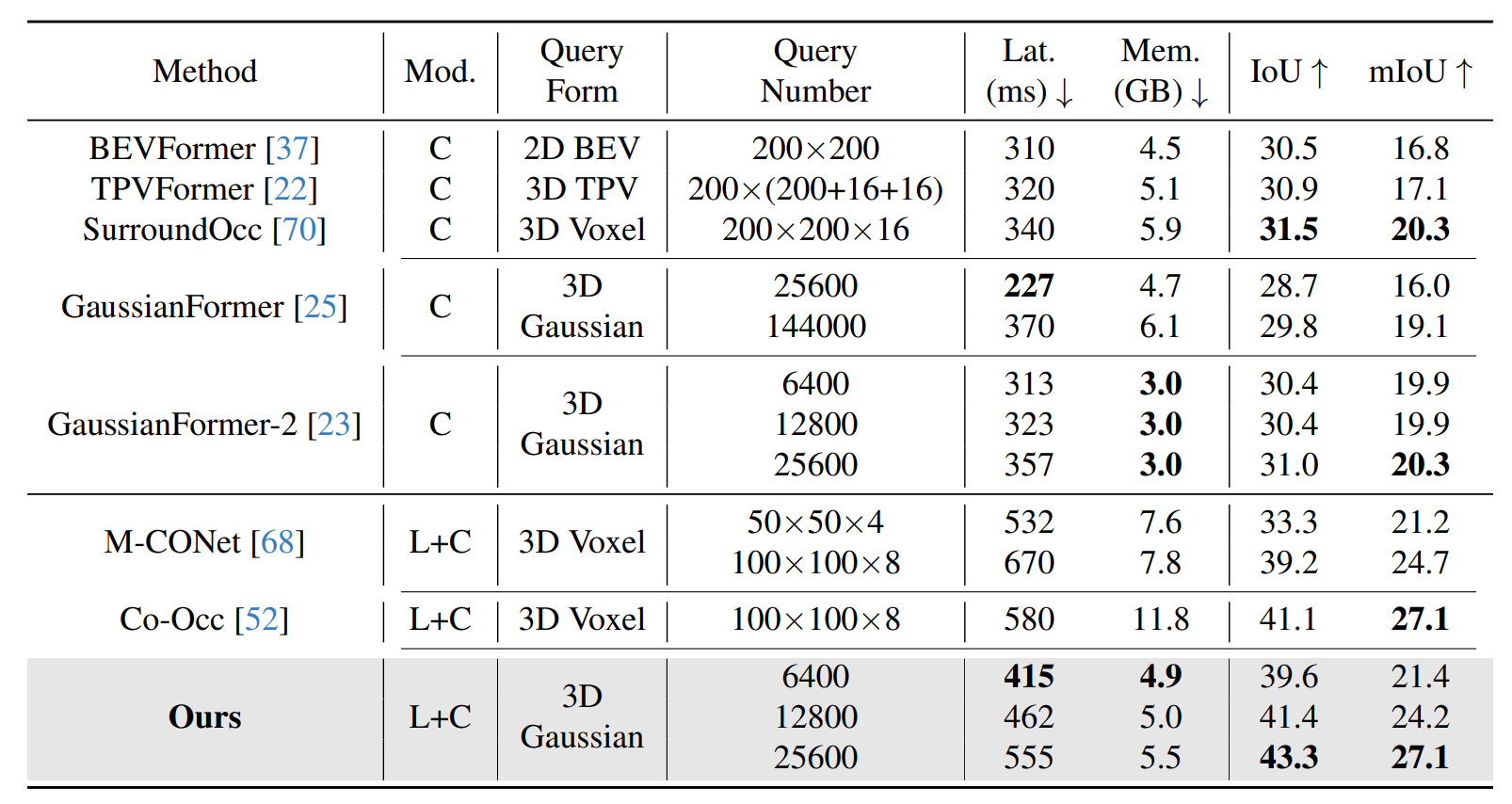

模型效率评估及高斯数量的影响

注

Table 4. Efficiency comparison of different methods and effect of Gaussian number on SurroundOcc [70] validation set. The results of our method are tested on one A40 GPU with batch size one during inference. The best is bolded within each modality.

我们在表 4 中评估并比较了我们方法与其他方法的延迟和内存消耗。我们的模型在实现基于多模态融合的预测性能的同时,保持了与仅使用摄像头的方法大致相同的低内存使用量。与 Co-Occ [52] 相比,我们的方法节省了大约 50% 的内存消耗,使其更适合在自动驾驶车辆上进行车载运行。此外,我们的方法仅使用 25,600 个高斯和 28 个通道,而 Co-Occ [52] 需要 80,000 个查询和 128 个通道来实现类似的性能,这表明我们的方法有潜力实现更高效的通信,适用于车联网或多机器人协作。我们的方法的延迟高于基于视觉的流程,这主要是由于 3D 可变形注意力操作引入的计算开销。我们还在表 4 中检查了高斯数量对模型性能的影响。随着高斯数量的增加,延迟和内存消耗上升,而 IoU 和 mIoU 指标稳步提高。

4.4. 消融研究

为了分解两个设计模块带来的性能提升,我们在表 5 中进行了广泛的消融实验,以验证我们的设计选择。我们观察到,提出的体素到高斯初始化和激光雷达引导的 3D 可变形注意力模块都为 GaussianFormer3D 的卓越性能做出了贡献。体素到高斯初始化显著提高了模型检测小物体(如行人、交通锥)和大面积表面(如人造结构、植被)的能力。这验证了多扫描激光雷达在为高斯提供占据空间准确几何信息方面的有效性。我们还注意到,激光雷达引导的 3D 可变形注意力机制增强了模型对动态车辆(如自行车、公交车、汽车、摩托车、拖车、卡车)和近路表面(如可行驶表面、平坦区域、人行道、地形)的预测能力,这些区域中的物体由激光雷达点检测到,并且对周围摄像头可见。在这些区域中,激光雷达点和相应的图像像素在提升的 3D 特征空间中相关联,使模型能够检索到近路和近路物体的聚合融合特征。

4.5. 定性结果

我们在图 3 中可视化了 3D 高斯和占据,以定性地验证 GaussianFormer3D 对于道路场景的有效性。我们的方法能够准确预测周围环境的语义和细粒度几何结构。在某些情况下,它甚至通过在缺乏语义标注的区域完成占据,超过了真实标注。我们在图 4 中给出了我们的方法在非道路场景上的定性结果。我们的方法能够预测对非道路自动驾驶至关重要的类别的语义占据,例如泥泞和水坑。我们还在图 5 中将我们的方法与 GaussianFormer [25] 进行了比较。我们方法中的高斯在尺度和形状上更具适应性,精确地出现在物体占据区域的长距离和短距离区域内,这得益于激光雷达传感器。此外,与在固定分辨率上进行训练和预测的基于体素的离散化方法相比,我们的方法可以在没有额外训练成本的情况下预测多分辨率语义占据,这归功于高斯的连续性属性。这一属性使得在某些区域以更高分辨率进行推理时能够实现更准确、更平滑的预测,如图 6 所示。请在补充材料中查看更多定性结果。

5. 结论

在本文中,我们提出了 GaussianFormer3D,这是一个基于 3D 高斯场景表示和 3D 可变形注意力的新型多模态语义占据预测框架。我们引入了一种体素到高斯初始化策略,为 3D 高斯提供来自激光雷达数据的准确几何先验,并设计了一种激光雷达引导的 3D 可变形注意力机制,用于在提升的 3D 空间中用激光雷达 - 摄像头融合特征细化 3D 高斯。广泛的实验表明,GaussianFormer3D 在实现准确和细粒度的语义占据预测方面是有效的。在未来,我们计划探索我们的多模态 3D 高斯场景表示在多机器人协调中的应用。

补充材料

A. 相关工作

单模态语义占据预测

语义占据预测(也称为语义场景补全)最初被提出用于预测室内场景中所有体素的占据和语义状态 [9, 34, 61, 86]。

基于视觉和激光雷达的流程首先被探索,并进一步扩展到室外环境,尤其是自动驾驶场景 [1, 4, 39, 62]。解决这一挑战性任务的关键在于学习一种信息丰富且紧凑的场景表示,常见的解决方案包括基于 3D 体素的表示 [77, 93]、基于 2D 鸟瞰图(BEV)的表示 [37, 79] 和基于三视图(TPV)的表示 [22]。

基于体素的方法利用离散化的体素来表示 3D 空间,并将来自 2D 图像 [5, 18, 26, 36, 43, 47, 48, 53, 69, 70, 84, 88, 91] 或 3D 点云 [6, 10, 41, 46, 50, 57, 58, 73, 75, 76, 80] 的语义和几何信息转换为体素特征向量。这些方法能够有效捕捉复杂的结构,但由于基于体素的表示的密集性,导致存储和计算成本高昂。此外,由于自动驾驶场景中存在大量空体素,其中大部分成本是不必要的。

基于 BEV 的表示在 3D 目标检测 [37, 79] 中取得成功后,也被应用于语义占据预测 [24, 38, 82]。TPV 表示 [22] 在 BEV 的基础上增加了两个额外的垂直平面,并已在基于视觉 [22, 24] 和激光雷达 [95] 的语义占据网络中使用。尽管基于 BEV 和 TPV 的方法缓解了由空网格引起的冗余问题,但它们的压缩方案不可避免地导致了信息丢失。

3D 高斯绘制 [28] 提供了一种富有表现力且紧凑的场景表示,已在基于视觉的 3D 语义占据预测 [13, 23, 25] 中被探索。GaussianFormer [25] 将自动驾驶场景表示为一组 3D 高斯,旨在仅对物体占据的区域进行建模,这显著提高了预测效率并减少了内存消耗。

B. WildOcc 数据集

WildOcc [83] 是基于 RELLIS-3D [27] 注释的第一个非道路 3D 语义占据数据集。它包含大约 10,000 个激光雷达扫描,与单目图像配对。激光雷达扫描使用 64 通道的 Ouster OS1 激光雷达收集,而图像是使用 Basler acA1920-50gc 相机以 10Hz 的频率捕获的,分辨率为 1200×1920。该数据集提供了从语义标注的激光雷达点派生的语义占据标签,覆盖的空间范围为 [−20m,0m]×[−10m,10m]×[−2m,6m],体素分辨率为 0.2m。

基于 RELLIS-3D [27] 的分割文件,我们过滤掉了 WildOcc 中缺少对应语义占据标签、激光雷达姿态或地面真实深度的样本,最终获得了 7399、1249 和 1399 个样本,分别用于训练、验证和测试。测试集最初包含 11 个类别。然而,为了确保与 [83] 中的基线具有可比性,我们遵循相同的类别选择策略,考虑包括草地、树木、灌木、障碍物、水坑、泥泞和碎石等语义类别,同时将剩余标签归入“其他”类别。每个类别的百分比分布如图 7 所示。

该数据集的一个关键挑战是训练/验证集与测试集之间存在显著的分布差异。特别是,如图 7 所示,与其它类别相比,障碍物和碎石类别在测试集中的出现频率极低。具体来说,测试集仅包含 273 和 233 个体素用于障碍物和碎石,分别仅占占据体素的 0.0008% 和 0.0007%。这种严重的类别不平衡对模型性能构成了挑战,因为有限的训练数据可能会阻碍对这些代表性不足的类别的准确预测。此外,捕获的特征不足进一步复杂化了预测过程,使得对这些类别的可靠推断变得更加困难。

C. 评估指标

对于评估指标,我们采用了交并比(IoU)和平均交并比(mIoU),遵循 MonoScene [5]。IoU 和 mIoU 可以计算如下:

IoU=TP=c0+FP=c0+FN=c0TP=c0,mIoU=∣C′∣1i∈C′∑TPi+FPi+FNiTPi

其中,TP、FP 和 FN 分别表示真正例、假正例和假负例的数量,$ c_0 $ 表示空类别,$ C' $ 表示非空类别集合。

D. 实现细节

对于多视图图像,我们仅应用了光度失真增强、图像归一化和图像填充。

在评估过程中,我们没有应用任何测试时增强技术。对于 3D 可变形注意力,DFA3D [1:1] 已经证明,3D 特征空间中的三线性插值可以转换为深度加权的双线性插值。这意味着在实现中,3D 可变形注意力可以转换为深度加权的 2D 可变形注意力,以同时保持理论等价性和提高效率。因此,我们利用 DFA3D [1:2] 中实现的深度加权 2D 可变形注意力运算符(使用 CUDA)来进行 3D 可变形注意力。

E. 补充实验

E.1. 定性结果

WildOcc [83] 验证集和测试集的定性结果

我们在图 8 中展示了模型在 WildOcc [83] 验证集和测试集上的可视化结果。从验证集和测试集中各选取了两个具有代表性的样本进行展示。值得注意的是,验证集和测试集中的所有序列在训练过程中均未见过。类别分布已在附录 B 中报告。在第一个验证样本(第一行)中,我们的方法成功预测了碎石区域(用红色框标出),这对应于相机视图中的岩石堆。在第二个验证样本中,我们的模型有效地捕捉到了场景中的障碍物结构。这些结果表明,即使训练数据有限,我们的模型也能够学习语义占据。在测试集样本(最后两行)中,我们的方法准确地重建了大面积连续表面,如草地和树木,并且有效地检测到了不规则物体和地形,如灌木和泥泞,如红色框中所示。总体而言,我们的预测结果与真实标注高度相似,特别是在保留各种地形类型的几何结构方面,包括草地、树木、碎石和障碍物。

Occ3D [64] 验证集的定性结果

我们在图 9 中提供了模型在 Occ3D [64] 验证集上的可视化结果。我们的方法实现了细粒度的语义占据预测,并且偶尔甚至超过了真实标注。尽管在某些区域占据的真实标注是稀疏的并且存在缺失,但我们的模型能够准确地恢复这些未标注区域的语义信息。

SurroundOcc 验证集的多分辨率语义占据预测

我们在图 10 中提供了更多关于多分辨率语义占据预测的定性结果。如图 10 中红色框所示,我们观察到高分辨率预测在某些区域实现了更准确和平滑的占据结果。尽管高斯是以固定分辨率的真实标注进行监督的,但由于其连续建模属性,相同的高斯表示仍然可以生成多分辨率预测。这一优势消除了训练多个模型以预测不同分辨率占据的需求,并且在保持高预测精度的同时节省了相同的高斯,这显著缩短了算法部署时间并节省了计算资源。

不同高斯初始化策略的可视化比较

我们在图 11 中提供了不同高斯初始化策略的可视化比较结果。与随机初始化相比,我们设计的体素到高斯(V2G)初始化策略能够为 3D 高斯提供来自激光雷达数据的准确位置和几何先验,为后续基于 3D 可变形注意力的高斯细化铺平了道路。

E.2. 定量结果

不同天气条件下的模型性能

为了分解不同天气条件下的性能提升,我们根据气候和光照条件对 nuScenes [4] 数据集中的场景进行了分组。我们在表 7 中展示了 GaussianFormer3D 和 GaussianFormer [25] 的结果。与仅使用摄像头的基线 GaussianFormer 相比,我们的方法在所有天气条件下均显示出性能提升,验证了我们模型的有效性和鲁棒性。由于引入了激光雷达传感器,GaussianFormer3D 在极端气候(雨天)和低光照条件(夜间)下相较于仅使用摄像头的基线展现出显著的性能提升。为了公平比较,两项实验均采用了 25,600 个高斯。